Нелинейный классификатор. Многослойный персептрон

5.4. Построение нейронной сети

Существует два подхода к задаче построения нейронной сети-классификатора. Первый подход заключается в построении сети, варьируя архитектуру. Данный метод основан на точной классификации прецедентов. Второй подход состоит в подборке параметров (весов и порогов) для сети с заданной архитектурой.

5.4.1 Алгоритм, основанный на точной классификации множества прецедентов. Опишем общую идею метода. За основу берется один нейрон. Далее наращиваем нейрон, пока не получим правильную классификацию всех прецедентов.

Рассмотрим более подробно алгоритм. Начинаем с одного нейрона  , называемого мастером. После его тренировки получаем разделение

множества

, называемого мастером. После его тренировки получаем разделение

множества  на

на  и

и  . Если

. Если  содержит вектора из двух классов, то

вводим новый узел

содержит вектора из двух классов, то

вводим новый узел  , называемый последователем.

, называемый последователем.

Таким образом, на первом слое нейронов находится один мастер и несколько последователей. Никакие вектора из разных классов не имеют одинакового выхода из первого слоя.

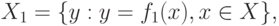

– отображение, задаваемое первым слоем.

– отображение, задаваемое первым слоем.Аналогичным образом строим второй слой, третий слой и т.д.

Утверждение. При правильном выборе весов каждый очередной слой правильно классифицирует все вектора, которые правильно классифицировал мастер и еще хотя бы один вектор.

Таким образом, получаем архитектуру, имеющую конечное число слоев, правильно классифицирующие все прецеденты.

Нейроны первого слоя – это биссекторы, разделяющие пары. Второй

слой – нейроны  , определяющие полиэдры. Третий слой – нейроны

, определяющие полиэдры. Третий слой – нейроны  ,

определяющие классы.

,

определяющие классы.

Основным недостатком данного метода является слишком большое количество нейронов.

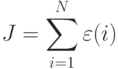

5.4.2. Алгоритм, основанный на подборе весов для сети с заданной архитектурой. Идея данного метода состоит в том, чтобы ввести критерий в виде функции стоимости, которую необходимо минимизировать.

Пусть

-

– число слоев в сети;

– число слоев в сети; -

– число нейронов в слое

– число нейронов в слое  , где

, где  ;

; -

– число выходных нейронов;

– число выходных нейронов; -

– размер входа;

– размер входа; -

– входной вектор признаков;

– входной вектор признаков; -

a – выходной вектор, который должен быть правильно классифицирован.

a – выходной вектор, который должен быть правильно классифицирован.

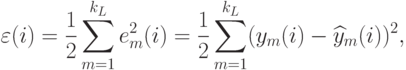

Текущем состоянии сеть при обучении дает результат  не совпадающий с

не совпадающий с  . Обозначим:

. Обозначим:

– число прецедентов;

– число прецедентов;  – ошибка на

– ошибка на  -ом прецеденте;

-ом прецеденте;

.

.  – функция всех синоптических весов и порогов.

Таким образом, целью обучения является решение оптимизационной задачи:

– функция всех синоптических весов и порогов.

Таким образом, целью обучения является решение оптимизационной задачи:

– множество синоптических весов.

– множество синоптических весов.Пусть  – выход

– выход  -ого нейрона

-ого нейрона  -ого слоя;

-ого слоя;  – весовой вектор (включая порог)

– весовой вектор (включая порог)  -ого нейрона в

-ого нейрона в  -ом слое,

т.е.

-ом слое,

т.е.  , где

, где  а – число

нейронов в

а – число

нейронов в  -ом слое. Таким образом,

-ом слое. Таким образом,  – разрывная функция

– разрывная функция  переменных, где

переменных, где

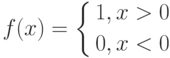

разрывна, т.к. разрывна функция активации

разрывна, т.к. разрывна функция активации  :

: