| Россия, Москва |

Нечеткие и гибридные нейронные сети

Гибридный алгоритм обучения нечетких сетей

Параметры, подлежащие адаптации, разделяются на две группы:

- первая состоит из параметров

линейного третьего

слоя;

линейного третьего

слоя; - вторая состоит из параметров нелинейной функции принадлежности первого слоя.

Уточнение параметров проводится в два этапа.

На первом этапе при фиксации определенных значений параметров функции

принадлежности путем решения системы линейных уравнений рассчитываются

параметры  полинома TSK.

полинома TSK.

При известных значениях функции принадлежности преобразование, реализуемое сетью, можно представить в виде

![\begin{align*}

y(x) & = \sum_{i=1}^M w_i(p_{i0} + \sum_{j=1}^N p_{ij} x_j).\\

w_i & =[\prod_{j=1}^N \mu_A^{(i)}(x_j)] / \sum_{k=1}^N

[\prod_{j=1}^N \mu_A^{(k)}(x_j)] = const.

\end{align*}](/sites/default/files/tex_cache/121f77d725b5b5a1786906b9ccd9335b.png)

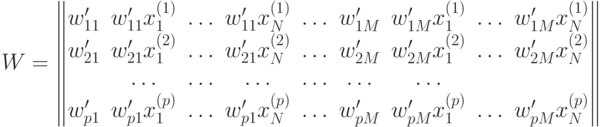

При  обучающих выборках

обучающих выборках  и замене выходного

сигнала сети ожидаемым значением

и замене выходного

сигнала сети ожидаемым значением  получим систему из

получим систему из  линейных

уравнений вида

линейных

уравнений вида

где

- уровень активации (вес)

- уровень активации (вес)  -го правила при

предъявлении

-го правила при

предъявлении  -го входного

вектора

-го входного

вектора  .

.

Размерность матрицы  равна

равна  , при

этом обычно количество строк

(количество выборок) значительно больше количества столбцов. Решение этой

системы уравнений можно получить за один шаг при помощи псевдоинверсии

матрицы

, при

этом обычно количество строк

(количество выборок) значительно больше количества столбцов. Решение этой

системы уравнений можно получить за один шаг при помощи псевдоинверсии

матрицы  :

:

Псевдоинверсия матрицы заключается в решении задачи минимизации

На втором этапе (линейные параметры  -

фиксированы)

рассчитываются фактические выходные сигналы

-

фиксированы)

рассчитываются фактические выходные сигналы  ,

,  :

:

и градиент целевой функции  по параметрам первого слоя. Если

применяется

метод наискорейшего спуска, то формулы адаптации принимают вид

по параметрам первого слоя. Если

применяется

метод наискорейшего спуска, то формулы адаптации принимают вид

где  обозначает номер очередной итерации.

обозначает номер очередной итерации.

После уточнения нелинейных параметров вновь запускается процесс адаптации линейных параметров TSK (первый этап) и нелинейных параметров (второй этап). Этот цикл повторяется вплоть до стабилизации всех параметров процесса.

-

-