| Россия, Москва |

Радиальные нейронные сети

Математические основы радиальных сетей

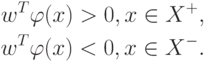

Математическую основу функционирования радиальных сетей составляет теорема Т. Ковера о распознаваемости образов, в соответствии с которой нелинейные проекции образов в некоторое многомерное пространство могут быть линейно разделены с большей вероятностью, чем при их проекции в пространство с меньшей размерностью.

Если вектор радиальных функций в  - мерном входном

пространстве

обозначить

- мерном входном

пространстве

обозначить  , то это пространство является нелинейно

, то это пространство является нелинейно  - разделяемым на

два пространственных класса

- разделяемым на

два пространственных класса  и

и  тогда,

когда существует такой вектор

весов

тогда,

когда существует такой вектор

весов  , что

, что

Граница между этими классами определяется уравнением  .

.

Доказано, что каждое множество образов, случайным образом размещенных в

многомерном пространстве, является  - разделяемым с

вероятностью 1 при

условии соответственно большой размерности этого пространства. На практике

это означает, что применение достаточно большого количества скрытых

нейронов, реализующих радиальные функции

- разделяемым с

вероятностью 1 при

условии соответственно большой размерности этого пространства. На практике

это означает, что применение достаточно большого количества скрытых

нейронов, реализующих радиальные функции  , гарантирует

решение задачи

классификации при построении всего лишь двухслойной сети: скрытый слой

должен реализовать вектор

, гарантирует

решение задачи

классификации при построении всего лишь двухслойной сети: скрытый слой

должен реализовать вектор  , а выходной слой может

состоять из

единственного линейного нейрона, который выполняет суммирование выходных

сигналов от скрытых нейронов с весовыми коэффициентами, заданными вектором

, а выходной слой может

состоять из

единственного линейного нейрона, который выполняет суммирование выходных

сигналов от скрытых нейронов с весовыми коэффициентами, заданными вектором  .

.

Простейшая нейронная сеть радиального типа функционирует по принципу

многомерной интерполяции, состоящей в отображении  различных

входных

векторов

различных

входных

векторов  из входного

из входного  -мерного

пространства во множество

из p чисел

-мерного

пространства во множество

из p чисел  . Для реализации этого процесса

необходимо

использовать

. Для реализации этого процесса

необходимо

использовать  скрытых нейронов радиального типа и задать такую

функцию

отображения

скрытых нейронов радиального типа и задать такую

функцию

отображения  , для которой выполняется условие интерполяции

, для которой выполняется условие интерполяции

Использование  скрытых нейронов, соединяемых связями с весами

с

выходными линейными нейронами, означает формирование выходных сигналов

сети путем суммирования взвешенных значений соответствующих базисных

функций. Рассмотрим радиальную сеть с одним выходом и

скрытых нейронов, соединяемых связями с весами

с

выходными линейными нейронами, означает формирование выходных сигналов

сети путем суммирования взвешенных значений соответствующих базисных

функций. Рассмотрим радиальную сеть с одним выходом и  обучающими парами

обучающими парами  . Примем, что координаты каждого из

. Примем, что координаты каждого из  центров узлов сети

определяются одним из векторов

центров узлов сети

определяются одним из векторов  , т.е.

, т.е.  .

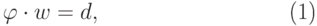

В этом случае взаимосвязь

между входными и выходными сигналами сети может быть определена системой

уравнений, линейных относительно весов, которая в матричной форме имеет

вид:

.

В этом случае взаимосвязь

между входными и выходными сигналами сети может быть определена системой

уравнений, линейных относительно весов, которая в матричной форме имеет

вид:

|

( 1) |

где  определяет радиальную функцию с

центром в

точке

определяет радиальную функцию с

центром в

точке  с вынужденным вектором

с вынужденным вектором  ,

, ![w=[w_1,w_2, \ldots, w_p]^T](/sites/default/files/tex_cache/910bf7bd52fe78f94ad0b6bf8e82576b.png) и

и ![d=[d_1,d_2, \ldots, d_p]^T](/sites/default/files/tex_cache/19e91e260f831ff2b5a82f549a32e105.png) .

.

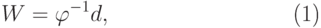

Доказано, что для ряда радиальных функций в случае

является невырожденной и при этом

неотрицательно определенной. Поэтому существует решение уравнения

(1) в

виде

является невырожденной и при этом

неотрицательно определенной. Поэтому существует решение уравнения

(1) в

виде |

( 2) |

что позволяет получить вектор весов выходного нейрона сети.

Теоретическое решение проблемы, представленное выражением (2), не может считаться абсолютно истинным по причине серьезного ограничения общих свойств сети, вытекающих из сделанных вначале допущений. При очень большом количестве обучающих выборок и равном ему количестве радиальных функций проблема с математической точки зрения становится бесконечной (плохо структурированной), поскольку количество уравнений начинает превышать число степеней свободы физического процесса, моделируемого уравнением (1). Это означает, что результатом такого чрезмерного количества весовых коэффициентов станет адаптация модели к разного рода шумам или нерегулярностям, сопровождающим обучающие выборки. Как следствие, интерполирующая эти данные гиперповерхность не будет гладкой, а обобщающие возможности останутся очень слабыми.

Чтобы их усилить, следует уменьшить количество радиальных функций и получить из избыточного объема данных дополнительную информацию для регуляризации задачи и улучшения ее обусловленности.