Реализация некоторых численных методов

8.3 Методы решения систем линейных уравнений

8.3.1 Общая характеристика и классификация методов решения

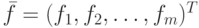

Рассмотрим систему линейных алгебраических уравнений (сокращенно — СЛАУ):

|

( 8.1) |

— матрица

— матрица  — искомый вектор,

— искомый вектор,  — заданный вектор. Будем предполагать, что определитель матрицы A отличен от нуля, т.е. решение системы (8.1) существует.

— заданный вектор. Будем предполагать, что определитель матрицы A отличен от нуля, т.е. решение системы (8.1) существует.Методы численного решения системы (8.1) делятся на две группы: прямые методы ("точные") и итерационные методы.

Прямыми методами называются методы, позволяющие получить решение системы (8.1) за конечное число арифметических операций. К этим методам относятся метод Крамера, метод Гаусса, LU-метод и т.д.

Итерационные методы (методы последовательных приближений) состоят в том, что решение системы (8.1) находится как предел последовательных приближений  при

при  , где

, где  — номер итерации. При использовании методов итерации обычно задается некоторое малое число

— номер итерации. При использовании методов итерации обычно задается некоторое малое число  и вычисления проводятся до тех пор, пока не будет выполнена оценка

и вычисления проводятся до тех пор, пока не будет выполнена оценка  . К этим методам относятся метод Зейделя, Якоби, метод верхних релаксаций и т.д.

. К этим методам относятся метод Зейделя, Якоби, метод верхних релаксаций и т.д.

Следует заметить, что реализация прямых методов на компьютере приводит к решению с погрешностью, т.к. все арифметические операции над переменными с плавающей точкой выполняются с округлением. В зависимости от свойств матрицы исходной системы эти погрешности могут достигать значительных величин.

8.3.2 Метод Гаусса

Запишем систему (8.1), в развернутом виде

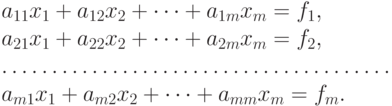

Метод Гаусса состоит в последовательном исключении неизвестных из этой системы. Предположим, что  . Последовательно умножая первое уравнение на

. Последовательно умножая первое уравнение на  и складывая с

и складывая с  -м уравнением, исключим

-м уравнением, исключим  из всех уравнений кроме первого. Получим систему

из всех уравнений кроме первого. Получим систему

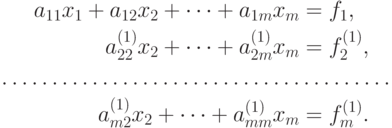

Аналогичным образом из полученной системы исключим  . Последовательно, исключая все неизвестные, получим систему треугольного вида

. Последовательно, исключая все неизвестные, получим систему треугольного вида

Описанная процедура называется прямым ходом метода Гаусса. Заметим, что ее выполнение было возможно при условии, что все  не равны нулю. Выполняя последовательные подстановки в последней системе, (начиная с последнего уравнения) можно получить все значения неизвестных.

не равны нулю. Выполняя последовательные подстановки в последней системе, (начиная с последнего уравнения) можно получить все значения неизвестных.

Эта процедура получила название обратный ход метода Гаусса.

Метод Гаусса может быть легко реализован на компьютере. При выполнении вычислений, как правило, промежуточные значения матрицы A не представляют интереса. Поэтому численная реализация метода сводится к преобразованию элементов массива размерности  , где

, где  -й столбец содержит элементы правой части системы.

-й столбец содержит элементы правой части системы.

Для контроля ошибки реализации метода используются, так называемые, контрольные суммы. Схема контроля основывается на следующем очевидном положении. Увеличение значения всех неизвестных на единицу равносильно замене данной системы контрольной системой, в которой свободные члены равны суммам всех коэффициентов соответствующей строки. Создадим дополнительный столбец, хранящий сумму элементов матрицы по строкам. На каждом шаге реализации прямого хода метода Гаусса будем выполнять преобразования и над элементами этого столбца, и сравнивать их значение с суммой по строке преобразованной матрицы. В случае не совпадения значений счет прерывается.

Один из основных недостатков метода Гаусса связан с тем, что при его реализации накапливается вычислительная погрешность.

Для систем порядка m число действий умножения и деления близко  и быстро растет с величиной

и быстро растет с величиной  .

.

Для того, чтобы уменьшить рост вычислительной погрешности применяются различные модификации метода Гаусса. Например, метод Гаусса с выбором главного элемента по столбцам, в этом случае на каждом этапе прямого хода строки матрицы переставляются таким образом, чтобы диагональный угловой элемент был максимальным. При исключении соответствующего неизвестного из других строк деление будет производиться на наибольший из возможных коэффициентов и, следовательно, относительная погрешность будет наименьшей.

Пример реализации метода Гаусса в Maxima приведен в функции ниже (применен метод без выбора главного элемента):

(%i1) gauss(a0,b0,n):=block([a,b,i,j,k,d], a:copymatrix (a0), b:copymatrix(b0), x:copymatrix(b0), for i:1 thru n-1 do ( for k:i+1 thru n do ( d:a[k,i]/a[i,i], for j:i+1 thru n do (a[k,j]:a[k,j]-a[i,j]*d), b[k,1]:b[k,1]-b[i,1]*d ) ), for i:n thru 1 step -1 do ( for j:i+1 thru n do ( b[i,1]:b[i,1]-a[i,j]*x[j,1]), x[i,1]:b[i,1]/a[i,i] ), x)$

Пример обращения к функции, реализующей метод Гаусса:

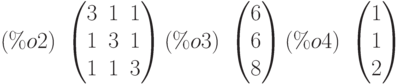

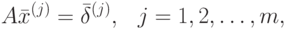

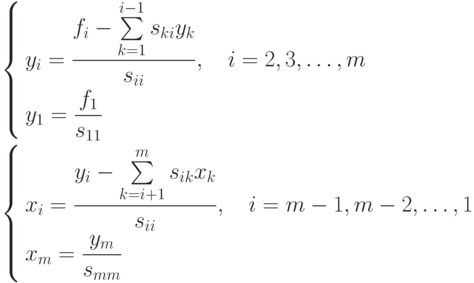

(%i2) aa:matrix([3,1,1],[1,3,1],[1,1,3]); bb:matrix([6],[6],[8]); zz:gauss(aa,bb,3);

Проверка вычислений показывает, что перемножение матрицы  на вектор решения

на вектор решения  дает вектор, совпадающий с вектором правых частей

дает вектор, совпадающий с вектором правых частей  .

.

(%i5) aa.zz;

Существует метод Гаусса с выбором главного элемента по всей матрице. В этом случае переставляются не только строки, но и столбцы. Использование модификаций метода Гаусса приводит к усложнению алгоритма увеличению числа операций и соответственно к росту времени счета.

Выполняемые в методе Гаусса преобразования прямого хода, приведшие матрицу  системы к треугольному виду позволяют вычислить определитель матрицы

системы к треугольному виду позволяют вычислить определитель матрицы

Метод Гаусса позволяет найти и обратную матрицу. Для этого необходимо решить матричное уравнение

– единичная матрица. Его решение сводится к решению

– единичная матрица. Его решение сводится к решению  систем

систем

–я компонента равна единице, а остальные компоненты равны нулю.

–я компонента равна единице, а остальные компоненты равны нулю.8.3.3 Метод квадратного корня

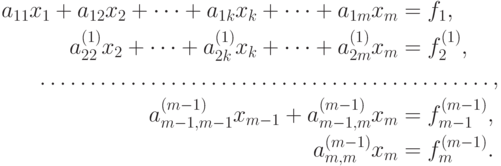

Метод квадратного корня основан на разложении матрицы  в произведение

в произведение

— верхняя треугольная матрица с положительными элементами на главной диагонали,

— верхняя треугольная матрица с положительными элементами на главной диагонали,  — транспонированная к ней матрица.

— транспонированная к ней матрица.Пусть  — матрица размером

— матрица размером  . Тогда

. Тогда

|

( 8.2) |

Из условия (8.2) получаются уравнения

|

( 8.3) |

Так как матрица  симметричная, не ограничивая общности, можно считать, что в системе (8.3) выполняется неравенство

симметричная, не ограничивая общности, можно считать, что в системе (8.3) выполняется неравенство  . Тогда

(8.3) можно переписать в виде

. Тогда

(8.3) можно переписать в виде

В частности, при  получится

получится

Далее, при  получим

получим

По приведённым формулам находятся рекуррентно все ненулевые элементы матрицы  .

.

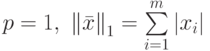

Обратный ход метода квадратного корня состоит в последовательном решении двух систем уравнений с треугольными матрицами.

Решения этих систем находятся по рекуррентным формулам:

Всего метод квадратного корня при факторизации  требует примерно

требует примерно  операций умножения и деления и m операций извлечения квадратного корня.

операций умножения и деления и m операций извлечения квадратного корня.

Пример функции, реализующей метод квадратного корня:

(%i1) holetsk(a0,b0):=block([L,Lt,x,y,i,j,k,n], n:length(a0), L:zeromatrix(n,n), for i:1 thru n do ( for j:1 thru i-1 do ( s:0, for k:1 thru j-1 do (s:s+L[i,k]*L[j,k]), L[i,j]:1/L[j,j]*(a0[i,j]-s) ), s:0, for k:1 thru i-1 do (s:s+L[i,k]^2), L[i,i]:sqrt(a0[i,i]-s) ),Lt:transpose(L), y:zeromatrix(n,1), x:zeromatrix(n,1), for i:1 thru n do ( s:0, for k:1 thru i-1 do (s:s+L[i,k]*y[k,1]), y[i,1]:(b0[i,1]-s)/L[i,i] ), for i:n thru 1 step -1 do ( s:0, for k:n thru i+1 step -1 do (s:s+Lt[i,k]*x[k,1]), x[i,1]:(y[i,1]-s)/Lt[i,i] ),x )$

Тест данной функции (решение системы  — матрица

— матрица  — квадратная симметричная матрица

— квадратная симметричная матрица  , результат решения — вектор

, результат решения — вектор  ):

):

(%i2) A:matrix([4,1,1],[1,4,1],[1,1,4])$ B:matrix([1],[1],[1])$

Результаты вычислений:

(%i4) x:holetsk(A,B);

Проверка:

(%i5) A.x;

8.3.4 Корректность постановки задачи и понятие обусловленности

При использовании численных методов для решения тех или иных математических задач необходимо различать свойства самой задачи и свойства вычислительного алгоритма, предназначенного для ее решения.

Говорят, что задача поставлена корректно, если решение существует и единственно и если оно непрерывно зависит от входных данных. Последнее свойство называется также устойчивостью относительно входных данных.

Корректность исходной математической задачи еще не гарантирует хороших свойств численного метода ее решений и требует специального исследования.

Известно, что решение задачи (8.1) существует тогда и только тогда, когда  . В этом случае можно определить обратную матрицу

. В этом случае можно определить обратную матрицу  и решение записать в виде

и решение записать в виде  .

.

Исследование устойчивость задачи (8.1) сводится к исследованию зависимости ее решения от правых частей  и элементов

и элементов  матрицы

матрицы  . Для того чтобы можно было говорить о непрерывной зависимости вектора решений от некоторых параметров, необходимо на множестве

. Для того чтобы можно было говорить о непрерывной зависимости вектора решений от некоторых параметров, необходимо на множестве  -мерных векторов принадлежащих линейному пространству

-мерных векторов принадлежащих линейному пространству  , ввести метрику.

, ввести метрику.

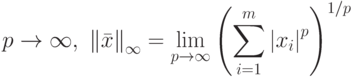

В линейной алгебре предлагается определение множества метрик  — норма

— норма  из которого легко получить наиболее часто используемые метрики

из которого легко получить наиболее часто используемые метрики

- при

,

, - при ,

- при .

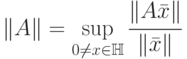

Подчиненные нормы матриц определяемые как  ,

соответственно записываются в следующем виде:

,

соответственно записываются в следующем виде:

Обычно рассматривают два вида устойчивости решения системы (8.1):

- по правым частям;

- по коэффициентам системы (8.1) и по правым частям.

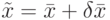

Наряду с исходной системой (8.1) рассмотрим систему с "возмущенными" правыми частями

возмущенная правая часть системы, а

возмущенная правая часть системы, а  возмущенное решение.

возмущенное решение.Можно получить оценку, выражающую зависимость относительной погрешности решения от относительной погрешности правых частей

— число обусловленности матрицы

— число обусловленности матрицы  (в современной литературе это число обозначают как

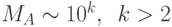

(в современной литературе это число обозначают как  ). Если число обусловленности велико (

). Если число обусловленности велико ( ), то говорят, что матрица

), то говорят, что матрица  плохо обусловлена. В этом случае малые возмущения правых частей системы (8.1), вызванные либо неточностью задания исходных данных, либо вызванные погрешностями вычисления существенно влияют на решение системы.

плохо обусловлена. В этом случае малые возмущения правых частей системы (8.1), вызванные либо неточностью задания исходных данных, либо вызванные погрешностями вычисления существенно влияют на решение системы.Если возмущение внесено в матрицу  , то для относительных возмущений решения имеет место следующая оценка:

, то для относительных возмущений решения имеет место следующая оценка:

В Maxima матричные нормы вычисляются посредством функции  . Синтаксис вызова:

. Синтаксис вызова:  , где

, где  — матрица,

— матрица,  — тип нормы,

— тип нормы,  может быть равен 1 (норма

может быть равен 1 (норма  ),

),  (норма

(норма  ),

),  (норма

(норма  ).

).

Пример вычисления указанных видов нормы в Maxima:

(%i1) A:matrix([1,2,3],[4,5,6],[7,8,9]);

(%i2) mat_norm(A,1);

(%i3) mat_norm(A,inf);

(%i4) mat_norm(A,frobenius);

Вычислим число обусловленности для плохо и хорошо обусловленных матриц:

(%i1) A:matrix([1,1],[0.99,1]);

(%i2) nrA:mat_norm(A,frobenius);

(%i3) A1:invert(A);

(%i4) nrA1:mat_norm(A1,frobenius);

(%i5) MA:nrA*nrA1;

Таким образом, для плохо обусловленной матрицы число обусловленности достигает почти 400.

Аналогичным путём (с использованием нормы Фробениуса) для матрицы ![B=\left[

\begin{matrix}

1 & 0 \\

0 & 1

\end{matrix}

\right]](/sites/default/files/tex_cache/df34f60a4619b2f2a05cfb9643036170.png) число обусловленности составило

число обусловленности составило  .

.

8.3.5 О вычислительных затратах

Один из важных факторов предопределяющих выбор того или иного метода при решении конкретных задач, является вычислительная эффективность метода. Учитывая, что операция сложения выполняется намного быстрее, чем операция умножения и деления, обычно ограничиваются подсчетом последних. Для решения СЛАУ методом Гаусса без выбора главного элемента требуется  умножений и делений, решение СЛАУ методом квадратного корня требует

умножений и делений, решение СЛАУ методом квадратного корня требует  и

и  операций извлечения корней. При больших значениях размерности

операций извлечения корней. При больших значениях размерности  , можно сказать, что вычислительные затраты на операции умножения и деления в методе Гаусса составляют величину

, можно сказать, что вычислительные затраты на операции умножения и деления в методе Гаусса составляют величину  , в методе квадратных корней

, в методе квадратных корней  .

.