Решение задач нейронными сетями

Устройство, способное находить точку условного минимума многочлена второго порядка при условиях вида  для

для  позволяет решать важную задачу - заполнять пробелы в данных (и, в частности, строить линейную регрессию).

позволяет решать важную задачу - заполнять пробелы в данных (и, в частности, строить линейную регрессию).

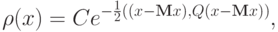

Предположим, что получаемые в ходе испытаний векторы данных подчиняются многомерному нормальному распределению:

где Mx - вектор математических ожиданий координат,  ,

,  - ковариационная матрица, n - размерность пространства данных,

- ковариационная матрица, n - размерность пространства данных,

Напомним определение матрицы  :

:  ,

,

где M - символ математического ожидания, нижний индекс соответствует номеру координаты.

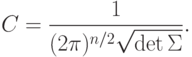

В частности, простейшая оценка ковариационной матрицы по выборке дает:

где m - число элементов в выборке, верхний индекс j - номер вектора данных в выборке, верхний индекс Т означает транспонирование, а  - произведение вектора-столбца на вектор-строку (тензорное произведение).

- произведение вектора-столбца на вектор-строку (тензорное произведение).

Пусть у вектора данных x известно несколько координат:  для

для  . Наиболее вероятные значения неизвестных координат должны доставлять условный максимум показателю нормального распределения - многочлену второго порядка

. Наиболее вероятные значения неизвестных координат должны доставлять условный максимум показателю нормального распределения - многочлену второго порядка  (при условии

(при условии  для

для  ). Эти же значения будут условными математическими ожиданиями неизвестных координат при заданных условиях.

). Эти же значения будут условными математическими ожиданиями неизвестных координат при заданных условиях.

Таким образом, чтобы построить сеть, заполняющую пробелы в данных, достаточно сконструировать сеть для поиска точек условного минимума многочлена

при условиях следующего вида:  для

для  . Матрица связей Q выбирается из условия

. Матрица связей Q выбирается из условия  , где

, где  - ковариационная матрица (ее оценка по выборке).

- ковариационная матрица (ее оценка по выборке).

На первый взгляд, пошаговое накопление  по мере поступления данных требует слишком много операций - получив новый вектор данных требуется пересчитать оценку

по мере поступления данных требует слишком много операций - получив новый вектор данных требуется пересчитать оценку  а потом вычислить

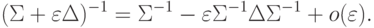

а потом вычислить  . Можно поступать и по-другому, воспользовавшись формулой приближенного обрашения матриц первого порядка точности:

. Можно поступать и по-другому, воспользовавшись формулой приближенного обрашения матриц первого порядка точности:

Если же добавка  имеет вид

имеет вид  , то

, то

|

( 10) |

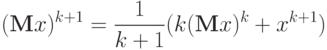

Заметим, что решение задачи (точка условного минимума многочлена) не меняется при умножении Q на число. Поэтому полагаем:

где 1 - единичная матрица,  - достаточно малое число,

- достаточно малое число,  - k +1 -й вектор данных,

- k +1 -й вектор данных,  - среднее значение вектора данных, уточненное с учетом

- среднее значение вектора данных, уточненное с учетом  :

:

В формуле для пошагового накопления матрицы Q ее изменение  при появлении новых данных получается с помощью вектора

при появлении новых данных получается с помощью вектора  , пропущенного через сеть:

, пропущенного через сеть:  , где z=Qy. Параметр

, где z=Qy. Параметр  выбирается достаточно малым для того, чтобы обеспечить положительную определенность получаемых матриц (и, по возможности, их близость к истинным значениям Q ).

выбирается достаточно малым для того, чтобы обеспечить положительную определенность получаемых матриц (и, по возможности, их близость к истинным значениям Q ).

Описанный процесс формирования сети можно назвать обучением. Вообще говоря, можно проводить формальное различение между формированием сети по явным формулам и по алгоритмам, не использующим явных формул для весов связей ( неявным ). Тогда термин "обучение" предполагает неявные алгоритмы, а для явных остается название "формирование". Здесь мы такого различия проводить не будем.

Если при обучении сети поступают некомплектные данные  с отсутствием значений некоторых координат, то сначала эти значения восстанавливаются с помощью имеющейся сети, а потом используются в ее дальнейшем обучении.

с отсутствием значений некоторых координат, то сначала эти значения восстанавливаются с помощью имеющейся сети, а потом используются в ее дальнейшем обучении.

Во всех задачах оптимизации существенную роль играет вопрос о правилах остановки: когда следует прекратить циклическое функционирование сети, остановиться и считать полученный результат ответом? Простейший выбор - остановка по малости изменений: если изменения сигналов сети за цикл меньше некоторого фиксированного малого  (при использовании переменного шага

(при использовании переменного шага  может быть его функцией), то оптимизация заканчивается.

может быть его функцией), то оптимизация заканчивается.

До сих пор речь шла о минимизации положительно определенных квадратичных форм и многочленов второго порядка. Однако самое знаменитое приложение полносвязных сетей связано с увеличением значений положительно определенных квадратичных форм. Речь идет о системах ассоциативной памяти [2.4, 2.5, 2.6, 2.7, 2.9, 2.10, 2.12].

Предположим, что задано несколько эталонных векторов данных  и при обработке поступившего на вход системы вектора x требуется получить на выходе ближайший к нему эталонный вектор. Мерой сходства в простейшем случае будем считать косинус угла между векторами - для векторов фиксированной длины это просто скалярное произведение. Можно ожидать, что изменение вектора x по закону

и при обработке поступившего на вход системы вектора x требуется получить на выходе ближайший к нему эталонный вектор. Мерой сходства в простейшем случае будем считать косинус угла между векторами - для векторов фиксированной длины это просто скалярное произведение. Можно ожидать, что изменение вектора x по закону

|

( 11) |

где h - малый шаг, приведет к увеличению проекции x на те эталоны, скалярное произведение на которые  больше.

больше.

Ограничимся рассмотрением эталонов, и ожидаемых результатов обработки с координатами  . Развивая изложенную идею, приходим к дифференциальному уравнению

. Развивая изложенную идею, приходим к дифференциальному уравнению

|

( 12) |

где верхними индексами обозначаются номера векторов-эталонов, нижними - координаты векторов.

Функция H называется " энергией " сети, она минимизируется в ходе функционирования. Слагаемое  вводится для того, чтобы со временем возрастала проекция вектора x на те эталоны, которые к нему ближе, слагаемое

вводится для того, чтобы со временем возрастала проекция вектора x на те эталоны, которые к нему ближе, слагаемое  обеспечивает стремление координат вектора x к

обеспечивает стремление координат вектора x к  . Параметр

. Параметр  определяет соотношение между интенсивностями этих двух процессов. Целесообразно постепенно менять

определяет соотношение между интенсивностями этих двух процессов. Целесообразно постепенно менять  со временем, начиная с малых

со временем, начиная с малых  , и приходя в конце концов к

, и приходя в конце концов к  .

.

Подробнее системы ассоциативной памяти рассмотрены в

"Нейронные сети ассоциативной памяти"

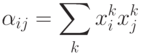

. Здесь же мы ограничимся обсуждением получающихся весов связей. Матрица связей построенной сети определяется функцией  , так как

, так как  вычисляется непосредственно при j -м нейроне без участия сети. Вес связи между i -м и j -м нейронами не зависит от направления связи и равен

вычисляется непосредственно при j -м нейроне без участия сети. Вес связи между i -м и j -м нейронами не зависит от направления связи и равен

|

( 13) |

Эта простая формула имеет чрезвычайно важное значение для развития теории нейронных сетей. Вклад k -го эталона в связь между i -м и j -м нейронами (  ) равен +1, если i -я и j -я координаты этого эталона имеют одинаковый знак, и равен -1, если они имеют разный знак.

) равен +1, если i -я и j -я координаты этого эталона имеют одинаковый знак, и равен -1, если они имеют разный знак.

В результате возбуждение i -го нейрона передается j -му (и симметрично, от j -го к i -му), если у большинства эталонов знак i -й и j -й координат совпадают. В противном случае эти нейроны тормозят друг друга: возбуждение i -го ведет к торможению j -го, торможение i -го - к возбуждению j -го (воздействие j -го на i -й симметрично). Это правило образования ассоциативных связей (правило Хебба) сыграло огромную роль в теории нейронных сетей.